Nieuwe methode om antwoorden van AI-chatbot te controleren

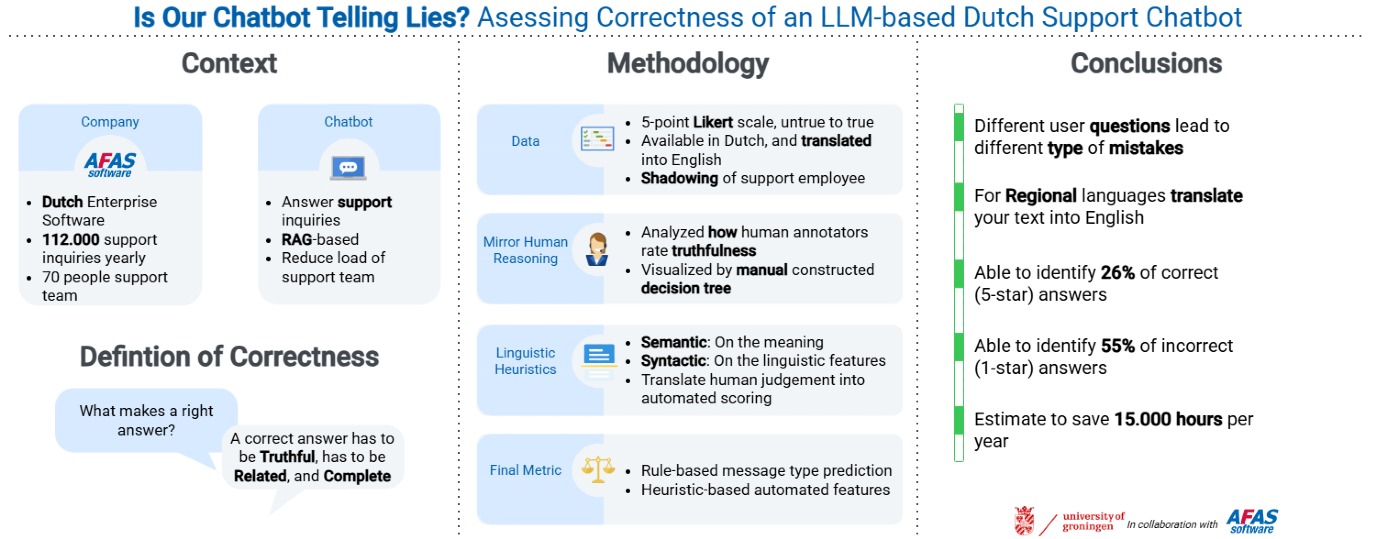

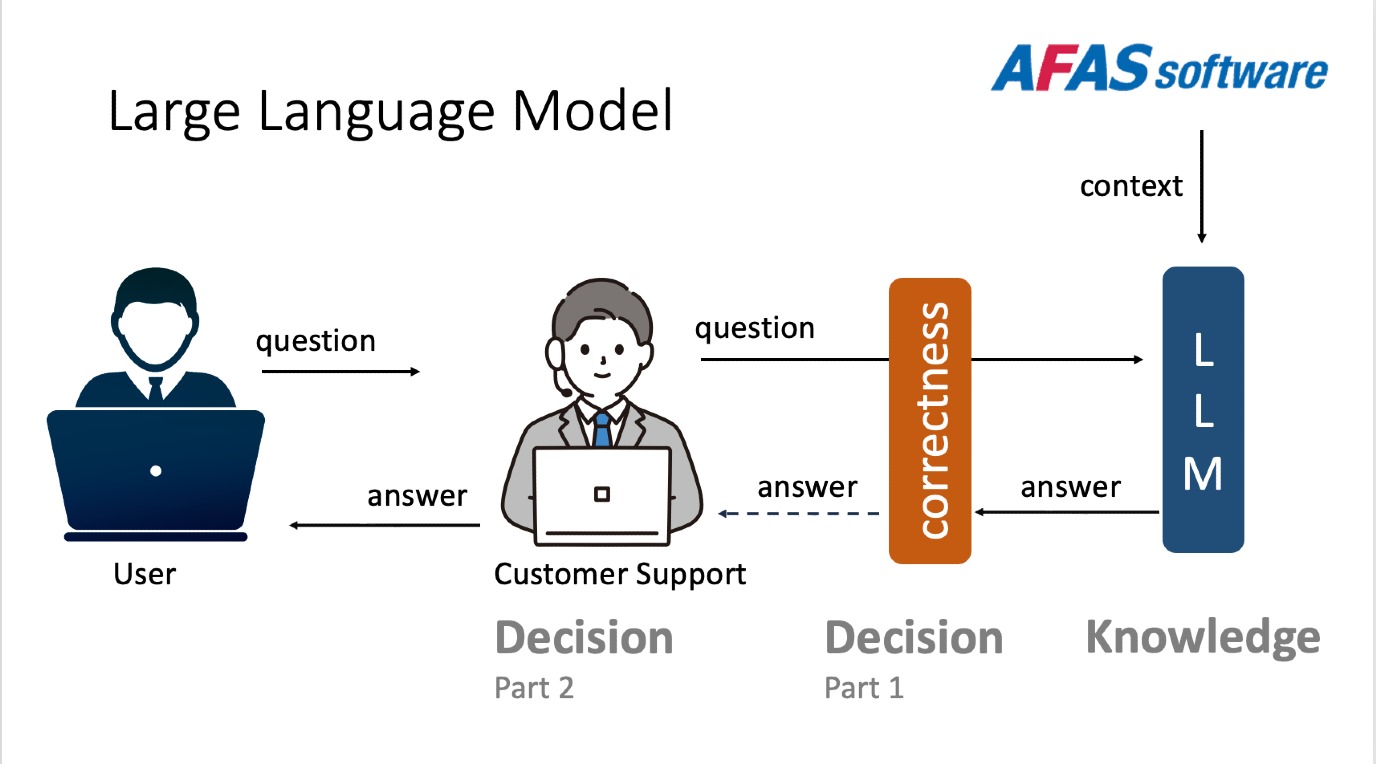

Hoe weet je of een chatbot de juiste antwoorden geeft? Dat is een belangrijke vraag voor bedrijven die communiceren met hun klanten via Large Language Models. Het Nederlandse bedrijf AFAS gebruikt chatbots om antwoorden te formuleren, die nu nog gecheckt worden door een werknemer voordat ze naar de klant gaan. Om dit proces te versnellen werkte het bedrijf samen met computerwetenschappers van de RUG aan de ontwikkeling van een raamwerk dat door AI geproduceerde antwoorden controleert. Het systeem werkt via dezelfde methoden die menselijke experts gebruiken om te zien of een antwoord juist is, en gebruikt daarbij interne documentatie als kennisbank.

FSE Science Newsroom | René Fransen

In de praktijk blijkt het eenvoudiger een foutief antwoord op te sporen dan een correct antwoord. Een raamwerk dat snel de duidelijk foute antwoorden filtert kan daarom de controle door mensen bespoedigen. Maar een interessantere wetenschappelijke uitdaging is het opsporen van antwoorden die correct lijken te zijn, maar belangrijke nuances missen. Daarmee wordt de kloof zichtbaar tussen schijnbaar juiste antwoorden en volledig juiste antwoorden.

Besparing van 15 duizend uren werk

De onderzoekers observeerden de klantenservicemedewerkers van AFAS om te begrijpen hoe ze tot de conclusie kwamen dat een antwoorde juist was. Ze combineerden dit met domein-specifieke informatie, die bestond uit interne documenten. De eerste resultaten laten zien dat deze aanpak potentie heeft: voor een eenvoudig ja/nee-antwoord en vragen rond instructies kan de aanpak tot wel 15 duizend uren werk per jaar besparen.

Het AI-systeem is zelfs in staat de juistheid te bepalen in situaties waarvoor het niet getraind is. Dit toont een bredere wetenschappelijke mogelijkheid: het bouwen van AI-evaluatiesystemen die hun oordeel kunnen generaliseren en vervolgens toepassen op nieuwe taken, op een manier die de redenering van menselijke experts nabootst en niet alleen afhankelijk is van gekopieerde patronen.

Bovendien laten de resultaten zien hoe belangrijk de contextuele, organisatie-specifieke kennis is die uiteindelijk bepaalt of de conclusie van het AI-systeem juist en bruikbaar is. De hoofdauteur van het artikel, Ayushi Rastogi, formuleert het zo: ‘Voor deze bedrijfstak betekent het dat investeren in een goed gestructureerde interne documentatie en domeinkennis net zo belangrijk is als het ontwikkelen van geavanceerde AI-modellen. Zonder die basis kan zelfs de slimste AI geen betrouwbare en bruikbare uitkomsten opleveren.’

Referentie Herman Lassche, Michiel Overeem, Ayushi Rastogi: Is our chatbot telling lies? Assessing correctness of an LLM-based Dutch support chatbot. Journal of Systems and Software, online 2 december 2025.

Meer nieuws

-

17 februari 2026

De lange zoektocht naar nieuwe fysica

-

10 februari 2026

Waarom slechts een klein aantal planeten geschikt is voor leven